这是一个非常核心且重要的话题,可以说,SLAM是AR的“心脏”和“大脑”,没有SLAM,AR应用就无法将虚拟信息稳定、准确地叠加到现实世界中。

什么是SLAM?(What is SLAM?)

SLAM 是 Simultaneous Localization and Mapping 的缩写,中文翻译为 “同时定位与地图构建”。

它解决了一个经典的“鸡生蛋还是蛋生鸡”的问题:

- 定位: 设备(如手机或AR眼镜)需要知道自己在现实世界中的精确位置和姿态(方向)。

- 地图构建: 设备需要扫描并理解周围的环境,构建一个三维或二维的地图。

这两个问题是相互依赖的:你需要一张地图来确定自己的位置,但你又需要知道自己的位置才能构建这张地图。

SLAM技术就是在设备运动的过程中,实时地、同步地完成这两项任务。

为什么AR需要SLAM?(Why does AR need SLAM?)

想象一下,如果没有SLAM,AR会是什么样子?

你用手机打开一个AR应用,想把一个虚拟的茶杯放在你家的桌子上,手机可能会随机地把茶杯画在屏幕的某个位置,当你移动手机时,这个虚拟茶杯不会“粘”在桌子上,而是会随着你的移动而漂移、变形,甚至消失。

这显然不是我们想要的AR体验。

SLAM为AR提供了至关重要的能力:

- 理解空间: SLAM让设备能够“看懂”并“周围的环境,它能识别出哪里是平面(比如地板、桌面),哪里是边缘和角落。

- 稳定虚拟物体: 这是SLAM最核心的作用,它通过持续追踪设备的位置和姿态,确保虚拟物体能够“锚定”在现实世界的特定位置,当你绕着桌子走动时,虚拟茶杯应该始终停留在桌面上,大小和角度也会根据你的视角变化而保持真实感。

- 实现交互: 基于构建的环境地图,AR应用可以实现更高级的交互,你可以“推开”虚拟物体,让它从桌子的一边滑到另一边,因为它知道桌子的边界在哪里。

SLAM是连接虚拟世界和现实世界的桥梁。 它让数字内容能够像真实物体一样,遵守物理空间的规则,从而创造出无缝的、可信的增强现实体验。

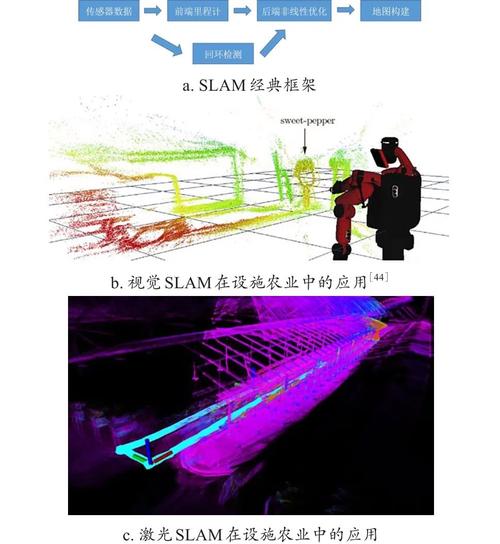

SLAM在AR中的核心工作原理

SLAM系统通常由以下几个关键模块组成,它们协同工作,形成一个循环:

A. 传感器数据采集

AR设备主要通过两种传感器来感知世界:

- 摄像头: 捕捉连续的视频流,这是视觉SLAM(V-SLAM)的核心输入。

- 惯性测量单元: 包含加速度计和陀螺仪,它测量设备的线性加速度和旋转角速度,提供设备自身的运动状态信息。

B. 前端 - 视觉里程计

这是SLAM的第一步,目标是估算设备在短时间内的相对运动。

- 做什么? 它分析连续的图像帧,通过特征点检测与匹配(比如ORB、SIFT等算法),找出图像中相同的点,然后根据这些点的位移变化,计算出设备自上一帧以来移动了多少、旋转了多少。

- 好比什么? 就像你盯着一个远处的固定物体,通过观察它在你视野中的移动,来估算你自己的头部转动。

C. 后端 - 优化与全局一致性

前端估算的相对运动会累积误差,时间越长,误差越大,后端的作用就是消除这些累积误差,优化全局轨迹和地图。

- 做什么? 它将前端所有时刻的位姿和地图点视为一个大的优化问题,通过图优化或滤波(如扩展卡尔曼滤波EKF)等算法,找到一个全局最优解,使得所有观测数据(匹配的特征点)与模型预测之间的误差最小。

- 好比什么? 你在一条不熟悉的路上走了很久,感觉有点迷路,这时你抬头看到了一个熟悉的路牌(回环检测),你突然意识到之前的估算有偏差,于是你调整了整个路线,让最终的位置和地图变得准确。

D. 回环检测

这是解决累积误差的关键,也是实现“地图构建”的核心。

- 做什么? 当设备回到之前已经访问过的某个区域时,回环检测模块会识别出当前的场景和之前存储的地图片段是“同一地方”,一旦检测到回环,后端就会利用这个“新信息”来大幅修正之前的所有位姿和地图,使其保持一致。

- 好比什么? 你在逛一个大型商场,走了一圈后,突然发现一个熟悉的店铺,你知道自己已经回到了起点,于是你可以根据这个信息来校准和修正你之前绕行的整个路线图。

E. 建图

根据优化后的轨迹和观测到的特征点,系统构建出环境的几何模型,在AR中,这通常表现为:

- 稀疏点云: 一系列三维空间中的点,代表物体的边缘和角点。

- 半稠密/稠密地图: 包含更多表面信息,可以用于更高级的物理交互(如光照、遮挡)。

AR中主流的SLAM技术方案

根据使用的传感器不同,SLAM可以分为几种主要类型:

视觉SLAM (V-SLAM - Visual SLAM)

- 原理: 完全依赖摄像头作为传感器。

- 优点: 成本低,信息丰富(包含纹理、颜色等),功耗相对较低。

- 缺点: 对光照变化、纹理缺失(如白墙)的场景非常敏感,计算量大,容易在快速运动或纹理重复的场景下失败。

- 应用: 大多数智能手机AR应用(如Apple的ARKit、Google的ARCore)主要基于V-SLAM。

惯性SLAM (I-SLAM - Inertial SLAM)

- 原理: 完全依赖IMU传感器。

- 优点: 更新频率高(可达数百Hz),对快速运动鲁棒性好,不受光照和纹理影响。

- 缺点: 误差会随时间迅速累积(漂移),无法提供环境几何信息,无法进行回环检测。

- 应用: 通常不单独使用,而是作为V-SLAM的补充。

视觉惯性SLAM (VIO - Visual-Inertial Odometry / VINS-Mono)

这是目前AR领域最主流、最成熟的技术方案。

- 原理: 融合了摄像头和IMU的数据,利用VIO提供高频、短期的鲁棒运动估计,用V-SLAM提供低频、长期的绝对位置校正。

- 优点:

- 优势互补: 摄像头补充了IMU的长期漂移,IMU弥补了摄像头在快速运动和纹理缺失时的不足。

- 性能卓越: 能在各种复杂场景下(如快速移动、低光照)提供稳定、准确的定位和建图。

- 延迟低: 能够实现低延迟的位姿估计,这对于流畅的AR体验至关重要。

- 代表: ARKit 和 ARCore 的核心都是基于VIO技术,著名的开源项目 VINS-Mono 也是VIO的经典实现。

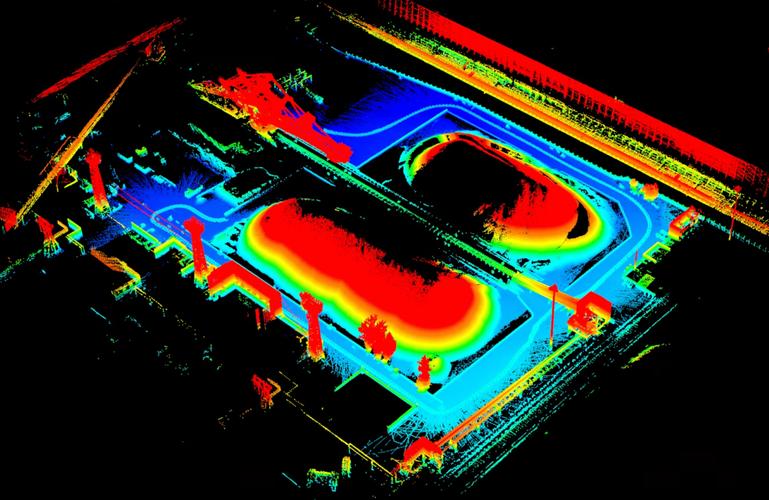

激光雷达SLAM (LiDAR SLAM)

- 原理: 使用激光雷达传感器,通过发射激光束并测量反射时间来直接获取高精度的3D点云数据。

- 优点: 精度极高,对光照和纹理不敏感,可以直接构建出非常精确的稠密地图。

- 缺点: 成本高昂,体积大,功耗高。

- 应用: 主要用于高端AR/VR头显(如Apple Vision Pro)和自动驾驶领域,为提供厘米级的定位精度和高质量的沉浸式体验。

挑战与未来趋势

尽管SLAM技术已经非常成熟,但在AR领域仍面临挑战:

- 动态环境: 如何处理场景中移动的人、车、宠物等动态物体,避免它们干扰地图构建和定位。

- 无纹理/重复纹理: 在纯白墙面、玻璃幕墙等场景下,V-SLAM会失效。

- 极端光照: 强光或昏暗环境会影响摄像头的性能。

- 计算效率: 在移动设备上实现实时、高精度的SLAM,对算法和硬件要求很高。

未来趋势:

- 深度学习融合: 利用深度学习进行更鲁棒的特征提取、场景理解和动态物体分割,提升SLAM在复杂场景下的表现。

- 多传感器融合: 结合更多传感器,如事件相机(对光照变化不敏感)、超宽带(提供厘米级绝对定位)等,构建更强大的定位系统。

- 云SLAM/分布式SLAM: 将计算任务部分或全部转移到云端,或由多个设备协同工作,以处理更大范围、更持久的AR应用场景(如大型多人AR游戏)。

SLAM是增强现实的基石。 它通过“同时定位与地图构建”,让AR设备能够感知、理解并锚定于现实世界,从而创造出稳定、可信、沉浸式的虚实融合体验,从手机上的AR滤镜到高端的AR/VR头显,其背后都离不开SLAM技术的强大支撑,而视觉惯性里程计正是当前实现这一目标最核心、最主流的技术路径。