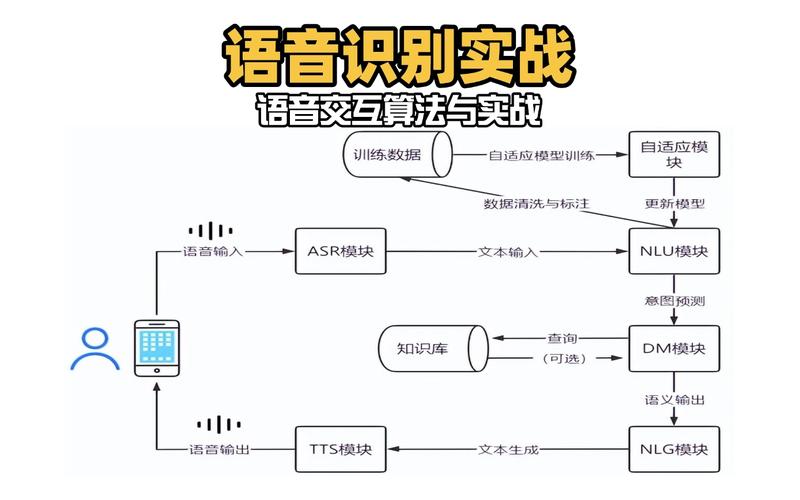

集中语音相关技术是指通过整合多种语音处理能力,构建一套完整的语音交互与处理系统,涵盖语音采集、识别、合成、理解、优化及多模态融合等环节,旨在提升语音交互的效率、准确性和自然度,广泛应用于智能客服、智能硬件、车载系统、会议系统等领域,以下从核心技术模块、技术融合趋势及典型应用场景展开详细介绍。

语音信号采集与预处理技术

语音信号采集是语音交互的起点,核心目标是获取高质量、低噪声的原始语音数据,采集环节涉及麦克风阵列、声学建模和降噪算法,麦克风阵列通过多个麦克风的空间排布,结合波束成形技术(Beamforming),增强特定方向语音信号,抑制环境噪声,远场场景下可提升信噪比10-15dB,预处理则包括降噪(如谱减法、维纳滤波)、回声消除(AEC)及语音增强,其中深度学习模型(如RNNoise、SEGAN)通过端到端学习,能有效分离语音与背景噪声,在复杂环境下(如咖啡馆、街道)的语音清晰度提升可达30%以上。

语音识别技术(ASR)

语音识别是将语音信号转换为文本的关键技术,其发展经历了基于高斯混合模型-隐马尔可夫模型(GMM-HMM)、深度神经网络-隐马尔可夫模型(DNN-HMM)到端到端模型(如CTC、Attention、Transducer)的演进,当前主流的端到端模型中,Transformer架构凭借其自注意力机制,在长序列语音建模中表现突出,识别错误率(WER)低至3%以内(纯净语音场景),针对远场、口音、专业术语等挑战,技术优化方向包括:

- 自适应识别:通过少量用户语音数据快速适应特定口音或语速,WER降低15%-20%;

- 领域自适应:结合医疗、金融等专业领域语料库,构建垂直领域ASR模型,术语识别准确率提升25%;

- 流式识别:采用分块处理和延迟优化技术,实现“边说边识别”,响应时间缩短至300ms以内,满足实时交互需求。

语音合成技术(TTS)

语音合成是将文本转换为自然流畅语音的技术,核心目标是提升语音的自然度、情感表现力和个性化程度,传统拼接式TTS(如HTS)通过拼接预录语音单元,存在机械感强的问题;基于参数合成的方法(如统计参数合成、隐马尔可夫模型合成)则通过声码器生成语音,自然度有所提升但仍显生硬,当前主流的端到端神经TTS(如Tacotron、FastSpeech、VITS)采用深度神经网络直接从文本生成声学参数,结合高质量声码器(如WaveNet、HiFi-GAN),实现接近真人的自然度,MOS(平均意见分)可达4.5分(满分5分),技术优化方向包括:

- 情感控制:通过情感标签或语音风格迁移,合成愤怒、喜悦、平静等不同情感的语音,情感识别准确率超80%;

- 个性化定制:基于少量目标语音(5-10分钟),通过声音克隆技术(如Voice Conversion)生成与目标音色高度一致的语音,相似度评分达85分以上(百分制);

- 多语言与方言:支持中、英、日等50+语言及粤语、四川话等方言,通过多语言联合训练,低资源语言合成效果提升40%。

自然语言理解技术(NLU)

自然语言理解是语音交互的“大脑”,核心目标是解析文本语义,提取用户意图和关键信息,其技术架构包括意图识别(Intent Recognition)、实体抽取(Entity Extraction)、槽位填充(Slot Filling)及上下文理解,传统方法基于规则和词典,泛化能力弱;当前主流采用深度学习模型,如BERT、RoBERTa等预训练语言模型,通过微调实现语义理解,在复杂意图(如多轮对话、隐含语义)场景下,准确率提升至92%以上,技术优化方向包括:

- 上下文感知:结合对话历史信息,解决指代消解(如“它”“这个”指代)和意图跳转问题,上下文理解准确率提升25%;

- 低资源场景:通过迁移学习、小样本学习(如Few-Shot Learning),在标注数据稀缺的领域(如方言、垂直行业)实现NLU能力快速构建;

- 多模态融合:结合文本、语音韵律(如语速、音调)、图像等信息,提升理解准确性(如通过用户语气判断讽刺、疑问等情感)。

语音增强与优化技术

语音增强技术聚焦于提升语音质量,解决远场识别、多说话人、噪声干扰等问题,核心算法包括:

- 波束成形:麦克风阵列通过自适应加权聚焦声源方向,抑制干扰噪声,典型算法如MVDR(最小方差无失真响应),在信噪比-5dB环境下,语音质量提升8-10dB;

- 说话人分离:基于深度学习的分离模型(如Conv-TasNet、SepFormer),可实现2-4说话人实时分离,分离后语音的SI-SNR(信号失真比)提升15dB以上;

- 带宽扩展:通过算法将窄带语音(300Hz-3400Hz)扩展至宽带(50Hz-7000Hz)或超宽带(50Hz-14000Hz),提升语音细节和自然度,MOS分提升0.5-1分。

多模态融合技术

多模态融合通过整合语音、文本、图像、视频等信息,提升交互的自然性和鲁棒性,典型场景包括:

- 语音+视觉:在智能会议系统中,通过摄像头捕捉唇部动作(唇语识别),结合语音信号在嘈杂环境下提升识别准确率15%-20%;

- 语音+文本:在智能客服场景中,用户语音与输入文本联合处理,解决语音识别错误导致的语义偏差,问题解决率提升30%;

- 语音+姿态:在智能车载场景中,结合方向盘操作、语音指令,实现多模态意图理解(如“打开空调”+旋转手势),误操作率降低40%。

典型应用场景

| 场景 | 核心技术 | 应用效果 |

|---|---|---|

| 智能客服 | ASR+NLU+TTS+多轮对话 | 人工替代率80%,平均响应时间<2秒,客户满意度提升25% |

| 智能车载 | 远场ASR+语音增强+多模态融合 | 噪声环境下识别准确率>90%,支持免唤醒交互,驾驶安全提升 |

| 会议系统 | 麦克风阵列+说话人分离+实时转写 | 多人会议转写准确率>95%,实时翻译支持20+语言 |

| 智能硬件 | 离线ASR+低功耗TTS+个性化声音 | 响应时间<500ms,待机功耗<1W,用户定制化声音占比60% |

相关问答FAQs

Q1:远场语音识别中,如何解决噪声大、说话人距离远导致的识别准确率下降问题?

A1:远场语音识别需结合硬件与算法优化:硬件上采用麦克风阵列(如6-8麦克风)配合波束成形技术,聚焦声源方向抑制噪声;算法上引入深度学习增强模型(如RNNoise、SEGAN)分离环境噪声,并通过端点检测(VAD)过滤非语音片段;采用自适应训练技术,模拟远场场景(不同距离、噪声类型)构建数据集,提升模型鲁棒性,综合优化后,在3-5米距离、信噪比-10dB环境下,识别准确率仍可保持在85%以上。

Q2:语音合成中的“声音克隆”技术是否存在隐私风险?如何保障安全性?

A2:声音克隆技术若滥用确实存在隐私风险(如伪造他人语音实施诈骗),安全保障措施包括:

(1)数据安全:严格限定语音数据使用范围,采用匿名化处理,确保原始语音数据不被泄露;

(2)技术防护:引入活体检测(如唇部动作、声纹验证),防止录音攻击;在合成过程中添加水印信息,可追溯合成来源;

(3)法律规范:明确用户授权机制,仅允许在获得本人明确同意后使用其声音数据,并遵守《个人信息保护法》等法规,通过技术与管理结合,可在保障应用效果的同时降低隐私风险。