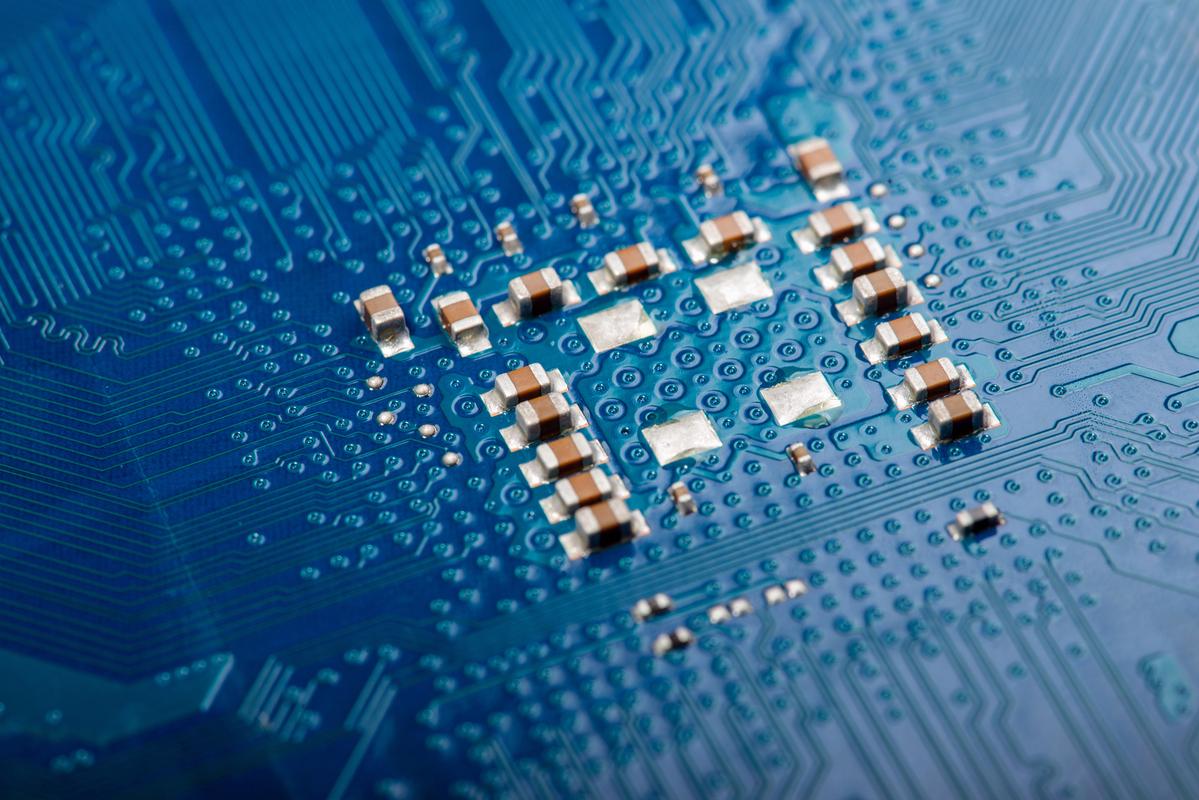

2025年是全球芯片技术取得重大突破的一年,在制程工艺、架构创新、材料应用等多个领域都展现出加速发展的态势,不仅推动了半导体产业的升级,也为人工智能、5G通信、物联网等新兴技术的落地奠定了坚实基础,这一年,芯片技术的突破既体现在摩尔定律延续的艰难探索中,也体现在突破传统架构限制的创新实践中,标志着行业进入“后摩尔时代”的技术多元化发展新阶段。

在制程工艺方面,10纳米及以下先进制程的量产成为竞争焦点,台积电在2025年率先实现10纳米制程的规模化生产,采用FinFET(场效应晶体管)技术,相比16纳米制程性能提升高达27%,功耗降低40%,主要应用于苹果A11仿生芯片等高端移动处理器,三星电子也紧随其后,推出基于10纳米制程的Exynos 9810芯片,通过优化晶体管结构和布线技术,提升了处理器在AI计算和图像处理中的性能,7纳米制程的研发进入关键阶段,台积电宣布采用极紫外光刻(EUV)技术推进7纳米工艺,预计在2025年量产,这一技术的突破将解决传统深紫外光刻(DUV)在7纳米及以下制程中遇到的分辨率瓶颈,进一步缩小晶体管尺寸,提升芯片集成度,中芯国际也宣布基于28纳米制程的HKMG(高K金属栅极)技术实现量产,并加速推进14纳米工艺的研发,标志着中国大陆在先进制程领域逐步缩小与国际领先水平的差距。

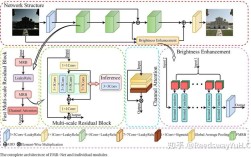

架构创新是2025年芯片技术突破的另一核心领域,传统冯·诺依曼架构在数据处理速度和能效比上逐渐遭遇瓶颈,针对AI、大数据等场景的计算需求,专用架构和异构计算成为重要发展方向,谷歌在2025年发布TPU(张量处理单元)第二代,专为深度学习优化,采用脉动阵列架构,相比第一代性能提升2-3倍,能效比提升高达30倍,广泛应用于AlphaGo、YouTube推荐系统等AI场景,英伟达也推出基于Volta架构的GV100 GPU,集成全新Tensor Core和张量处理单元,将AI训练性能提升至上一代产品的5倍,支持FP16、INT8等混合精度计算,满足自动驾驶、科学计算等复杂场景需求,在移动端,苹果A11仿生芯片采用自研的“神经引擎”(Neural Engine),专门处理AI任务,具备每秒600亿次运算能力,支持人脸识别、Animoji等AI功能,标志着移动端AI专用架构的成熟,ARM公司发布全新 DynamIQ 架构,通过可扩展的多核设计,支持从微控制器到服务器的多样化应用场景,提升了芯片在实时处理、多任务并行等方面的灵活性。

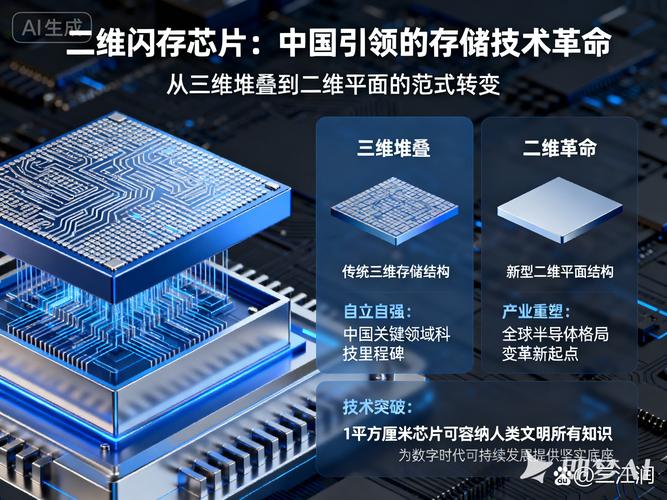

新材料与新技术的应用为芯片性能突破提供了新路径,传统硅基材料在物理极限下面临漏电、散热等问题,碳纳米管、二维材料等新兴材料的探索取得进展,IBM在2025年展示基于碳纳米管技术的芯片,成功制造出10000个晶体管的测试芯片,电子迁移率是硅的2倍,功耗降低50%,为后摩尔时代芯片材料替代提供了可能,在封装技术方面,2.5D和3D封装技术进一步成熟,台积电的CoWoS(Chip on Wafer on Substrate)和InFO(Fan-Out)技术实现多芯片高密度集成,将CPU、GPU、内存等不同功能的芯片封装在单一基板上,大幅提升数据传输速度,降低延迟,应用于苹果A11、AMD Ryzen系列处理器等高端芯片中,硅光子技术也开始进入商业化阶段,Intel推出基于硅光子技术的100G光收发模块,通过光信号替代电信号进行数据传输,解决了高速通信中的带宽和功耗问题,为5G基站、数据中心等场景提供了高效互联方案。

芯片技术的突破也离不开设计工具和生态系统的协同发展,2025年,电子设计自动化(EDA)工具加速支持先进制程和AI芯片设计,Synopsys、Cadence等公司推出支持7纳米制程和EUV技术的EDA解决方案,提升了芯片设计的精度和效率,在开源生态方面,RISC-V架构进一步获得产业界支持,谷歌、高通、西部数据等企业加入RISC-V国际基金会,推动基于开源指令集的芯片设计,降低了芯片研发门槛,促进了物联网、边缘计算等领域的创新,中国也在加快芯片生态建设,华为海思发布麒麟970芯片,集成NPU单元,成为全球首款内置独立AI处理器的手机芯片;寒武纪推出云端AI芯片思元100和边缘AI芯片思元220,构建覆盖“云-边-端”的AI芯片产品体系。

相关问答FAQs:

-

问:2025年芯片制程突破中,10纳米和7纳米工艺的核心区别是什么?

答:10纳米工艺是先进制程的初步量产阶段,主要采用FinFET技术和深紫外光刻(DUV),通过缩小晶体管尺寸和优化布线提升性能;而7纳米工艺则需要引入极紫外光刻(EUV)技术,解决传统DUV在分辨率上的瓶颈,进一步缩小晶体管间距,提升集成度和能效比,台积电的7纳米工艺相比10纳米性能提升20%,功耗降低40%,是制程工艺向更小节点迈进的关键一步。 -

问:为什么说2025年是AI芯片架构的“爆发年”?

答:2025年,谷歌TPU第二代、英伟达Volta架构GPU、苹果A11神经引擎等专用AI芯片架构集中推出,这些架构通过针对AI计算任务的优化(如脉动阵列、张量核心等),大幅提升了AI训练和推理的能效比,与传统通用架构相比,AI专用架构在特定场景下性能提升可达数倍甚至数十倍,推动了AI技术在消费电子、自动驾驶等领域的规模化落地,因此被称为AI芯片架构的“爆发年”。