ar增强现实技术的实现是一个涉及硬件、软件、算法和交互设计的系统性工程,其核心目标是将虚拟信息与真实环境无缝融合,为用户创造沉浸式的交互体验,从技术层面来看,实现AR应用需要经历多个关键环节,包括数据采集、空间定位、内容渲染、交互反馈以及系统集成等。

硬件基础是AR实现的物理支撑,当前主流的AR硬件设备可分为头戴式(如AR眼镜、头显)和移动设备(如智能手机、平板)两类,头戴式设备通常配备高分辨率显示屏、摄像头、传感器(陀螺仪、加速度计、深度传感器)以及计算单元,能够解放用户双手并提供更沉浸的视觉体验,移动设备则依赖内置的摄像头和传感器,通过屏幕显示AR内容,具有便携性和普及性优势,空间定位设备(如LiDAR激光雷达、UWB超宽带定位模块)和交互工具(如手势识别手套、眼动追踪仪)也是提升AR交互精准度和自然度的重要硬件组件。

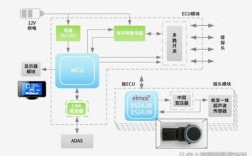

在软件层面,AR实现的核心是空间计算与内容渲染,空间计算包括环境感知、空间定位和场景理解三个步骤,环境感知通过摄像头捕捉真实场景,利用计算机视觉算法提取环境特征点;空间定位则基于SLAM(同步定位与地图构建)技术,实时计算设备在空间中的位置和姿态,确保虚拟内容与真实环境的坐标一致;场景理解进一步识别环境中的平面、物体和空间结构,为虚拟内容的放置提供依据,内容渲染方面,采用OpenGL、Vulkan等图形API,将虚拟模型、文字、动画等元素以3D形式叠加到真实画面中,并通过光照估计、阴影渲染等技术增强虚拟内容的真实感,苹果的ARKit和谷歌的ARCore都提供了SLAM、平面检测、光照估计等基础能力,开发者可基于这些框架快速构建AR应用。

交互设计是AR技术落地应用的关键,传统交互依赖触摸屏和物理按键,而AR技术则追求更自然的人机交互方式,如手势识别、语音控制、眼动追踪等,手势识别通过计算机视觉算法分析用户手部动作,实现虚拟物体的抓取、旋转和移动;语音控制借助自然语言处理技术,让用户通过语音指令操作AR内容;眼动追踪则通过眼球运动判断用户注意力焦点,实现动态内容推送或交互反馈,多模态交互(结合手势、语音、眼动)可进一步提升交互效率和用户体验。

系统集成与优化是确保AR应用稳定运行的保障,在开发过程中,需要平衡渲染性能与设备功耗,通过降低模型复杂度、优化渲染管线、采用动态加载等技术,保证在移动设备上流畅运行,网络通信(如云端渲染、实时数据同步)和跨平台兼容性(支持iOS、Android、Windows等系统)也是系统集成的重要考量,工业AR应用可能需要结合5G网络实现远程协作,而教育AR应用则需适配不同性能的移动设备。

相关问答FAQs:

-

问:AR技术与VR(虚拟现实)的主要区别是什么?

答:AR技术将虚拟信息叠加到真实环境中,用户仍可感知现实世界;而VR技术通过封闭式头显完全沉浸于虚拟场景,与现实世界隔离,AR依赖环境感知和空间定位,VR更侧重于虚拟世界的构建和交互。 -

问:普通开发者如何快速入门AR应用开发?

答:普通开发者可从成熟的AR框架入手,如苹果ARKit(iOS开发)、谷歌ARCore(Android开发)或Unity引擎的AR Foundation跨平台框架,学习SLAM基础、3D建模(如Blender)和交互设计,结合官方文档和示例项目逐步实践,即可快速构建简单AR应用。