这是一个非常核心且关键的技术领域,它决定了AR应用能否在真实世界中稳定、真实地运行,这项技术就是让虚拟物体能够“理解”并“适应”真实物理世界的过程。

什么是AR物理场景建模?

我们需要把它拆解成几个关键词:

- AR (Augmented Reality - 增强现实): 将虚拟信息叠加到真实世界视图上。

- 物理场景: 指的是现实世界中具有物理属性的空间,包括几何结构(墙壁、地面、桌子)、光照环境(太阳光、室内灯光)、物体材质(木头的纹理、金属的反光)以及运动状态(风扇的旋转、行人的走动)。

- 建模: 指的是通过技术手段,将这些复杂的物理属性数字化、结构化,变成计算机可以理解和处理的数据模型。

AR物理场景建模技术就是一套综合性的技术方案,其目标是在移动设备或AR眼镜上,实时地、高精度地重建出周围环境的几何、光照和语义信息,为虚拟物体的“安放”和“交互”提供坚实的基础。

为什么这项技术至关重要?

没有高质量的物理场景建模,AR应用会遇到以下致命问题:

- 虚拟物体“悬浮”在空中: 虚拟物体无法感知到地面或桌面,只能凭空放置,缺乏真实感。

- 与真实环境冲突: 虚拟桌子穿过了真实的墙壁,或者虚拟灯的光照与真实房间的光线完全不符,破坏了沉浸感。

- 交互体验差: 虚拟物体无法被真实世界遮挡(比如一个虚拟杯子放在真实杯子后面,应该被部分遮挡),也无法与真实物体发生物理碰撞(比如用手去推虚拟球,球应该掉到地上而不是穿过去)。

- 应用场景受限: 无法实现精准的AR测量、AR导航、工业维修指导等需要高精度空间理解的应用。

一句话总结:物理场景建模是连接虚拟世界与现实世界的“桥梁”,是AR从“酷炫”走向“可用”的关键。

核心技术构成

AR物理场景建模技术是一个多学科交叉的领域,主要由以下几个核心技术模块构成:

几何建模

这是最基础也是最核心的部分,解决“世界长什么样”的问题。

- 技术:

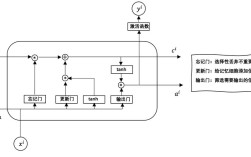

- SLAM (Simultaneous Localization and Mapping - 实时定位与地图构建): 这是AR的“心脏”,设备在移动过程中,实时计算自身在空间中的位置(定位),并同时构建周围环境的3D地图(建模),主流的SLAM方案有:

- VSLAM (视觉SLAM): 通过摄像头捕捉的图像序列来计算运动和构建地图,代表性开源库有 ORB-SLAM3, OpenVSLAM。

- LIDAR SLAM: 使用激光雷达进行测距,精度高,抗光照变化能力强,但成本高,主要用于自动驾驶和高端AR设备。

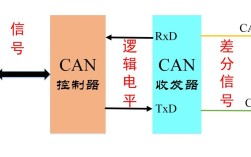

- IMU辅助SLAM: 结合惯性测量单元(陀螺仪、加速度计)的数据,可以弥补纯视觉SLAM在快速运动或纹理稀疏场景下的不足。

- 深度估计: 通过单目、双目摄像头或结构光传感器,估算出场景中每个像素点到相机的距离,从而生成深度图,为3D重建提供数据。

- NeRF (Neural Radiance Fields - 神经辐射场): 这是近年来的革命性技术,它不直接生成3D网格,而是训练一个神经网络来“学习”整个场景,通过这个网络,可以从任意视角渲染出极其逼真、具有新视角的图像,它擅长重建复杂几何和光照,但计算量大,目前多用于离线或云端处理,未来有望在端侧实现实时应用。

- SLAM (Simultaneous Localization and Mapping - 实时定位与地图构建): 这是AR的“心脏”,设备在移动过程中,实时计算自身在空间中的位置(定位),并同时构建周围环境的3D地图(建模),主流的SLAM方案有:

光照建模

解决“世界光线如何照射”的问题,直接影响虚拟物体的真实感。

- 技术:

- 环境光估计: 通过分析摄像头捕捉到的图像,推断出场景中的主要光源方向、颜色和强度,判断是来自左上方的暖色窗户光,还是来自正上方的冷色白炽灯光。

- 基于图像的光照: 从真实场景中提取环境贴图,并将其应用在虚拟物体表面,使其反射/折射特性与周围环境一致。

- 基于物理的渲染: 在虚拟物体材质上应用PBR模型,结合光照估计结果,计算出物体表面的颜色、高光、阴影等,使其在不同光照下表现出逼真的视觉效果。

语义建模

解决“世界由什么构成”的问题,从“几何物体”上升到“有意义物体”。

- 技术:

- 图像分割: 将图像中的像素分类到不同的类别,如“天空”、“地面”、“墙壁”、“人”、“车”、“植物”等。

- 实例分割: 更精细的分割,能区分出同一类别的不同个体,比如区分出图像中的“人1”、“人2”、“椅子1”、“椅子2”。

- 3D语义分割: 将2D的语义信息扩展到3D空间,使得SLAM构建的点云或网格地图中的每个点或面片都带有语义标签(这个点属于“地面”,那个面属于“墙壁”)。

- 目标检测与识别: 在3D空间中识别出常见的物体,如“门”、“窗户”、“桌面”、“床”等,并给出其精确的3D边界框。

动态场景理解

解决“世界是运动的”问题。

- 技术:

- 动态SLAM: 在SLAM过程中,通过光流法、背景建模等技术,区分出静态背景和动态前景(如走动的人、移动的汽车),只对静态部分进行地图构建,以提高定位和建图的稳定性。

- 运动分割: 将视频序列中的运动物体从背景中分离出来。

- 人体姿态估计: 识别人体的关键点,实现虚拟物体与人体(如手)的实时交互。

技术流程与挑战

典型工作流程:

- 数据采集: 设备(手机/AR眼镜)的摄像头、IMU等传感器持续采集图像和运动数据。

- 预处理: 对图像进行去畸变、色彩校正等操作。

- 核心处理:

- 并行处理: 同时运行多个线程。

- 几何重建: 运行VSLAM/LIDAR SLAM,得到相机的位姿和稀疏/半稠密的点云地图。

- 语义理解: 运行轻量级神经网络,对每一帧图像进行语义分割,识别出“地面”、“桌面”等。

- 光照估计: 从图像中提取环境光照信息。

- 融合与优化: 将几何、语义、光照信息融合成一个统一的、带物理属性的3D场景模型。

- 应用输出: 将这个模型提供给上层AR应用(如ARKit, ARCore),用于虚拟物体的放置、遮挡、光照渲染等。

主要挑战:

- 实时性 vs. 精度: 在移动设备有限的算力下,既要保证建模的实时性(流畅不卡顿),又要保证足够的精度(稳定不漂移),是一对永恒的矛盾。

- 鲁棒性: 如何应对弱光、强光、纹理重复(如一面白墙)、运动模糊等极端场景,防止SLAM系统“失效”。

- 尺度一致性: 确保重建的3D模型在尺度上是准确的,这对于AR测量等应用至关重要。

- 计算资源消耗: 高精度的建模(尤其是NeRF)需要巨大的计算量,如何在移动端实现是巨大的挑战。

- 动态物体处理: 如何准确、实时地理解和剔除动态干扰,重建出稳定的静态背景地图。

主流技术平台与未来趋势

主流平台:

- Apple ARKit: 在iOS设备上提供了世界追踪、平面检测、光照估计、人物遮挡、物体遮挡等强大的物理场景建模能力,是目前业界标杆。

- Google ARCore: 在Android设备上提供与ARKit类似的功能,支持平面检测、深度估计、环境光照等,是Android生态的基石。

- Meta (Facebook) Spark AR: 主要面向社交AR滤镜,其背后也依赖类似的技术来实现人脸追踪和场景理解。

未来趋势:

- NeRF的普及化: 随着芯片算力提升和算法优化,实时NeRF有望在端侧设备上实现,带来照片级的场景重建效果。

- 大语言模型与场景理解的结合: 让AR不仅能“看懂”场景,还能“理解”场景,AR眼镜能识别出“这是一个厨房,正在做饭”,并主动提供相关帮助。

- 云端协同建模: 将部分计算量大的任务(如高精度NeRF重建)放到云端处理,端侧只负责轻量级的实时追踪和渲染,实现“端云一体”的高质量AR体验。

- 多传感器深度融合: 更深层次地融合摄像头、LiDAR、毫米波雷达、IMU等多种传感器的数据,构建全天候、全场景的鲁棒物理模型。

- 数字孪生: AR物理场景建模技术是构建物理世界“数字孪生”的关键第一步,我们将能够为整个城市、工厂、家庭创建实时、高保真的数字副本,AR将成为我们与这个数字孪生世界交互的主要界面。

希望这份详细的解析能帮助你全面理解AR物理场景建模技术!