发展历程:从“规则”到“智能”

AI翻译的实现手段经历了两次重大的范式转移。

第一阶段:基于规则的机器翻译

这是最早期的翻译方法,在深度学习兴起前是主流。

- 核心思想:语言学家和程序员手动编写大量的翻译规则。

- 实现手段:

- 词典:建立源语言和目标语言之间的词汇对应表。

- 语法规则:编写源语言的语法分析规则(如句法结构)和目标语言的语法生成规则。

- 转换规则:定义如何将源语言的句法结构转换为目标语言的句法结构。

- 工作流程:

源语言句子 -> 语法分析 -> 结构转换 -> 词汇替换 -> 目标语言句子生成 - 优点:

- 可解释性强,规则明确。

- 对于特定领域的术语翻译准确率高(如果规则库足够完善)。

- 致命缺点:

- 规则爆炸:语言现象极其复杂,难以穷尽所有规则。

- 维护成本高:增加一种语言或修改规则都需要大量人力。

- 灵活性差:无法处理口语、新词、歧义等复杂情况。

第二阶段:统计机器翻译

这是AI翻译的第一个“智能”阶段,在21世纪初到2010年代中期占据主导地位。

- 核心思想:从大规模的双语平行语料库中自动学习翻译规律,而不是依赖人工规则。

- 实现手段:

- 双语语料库:需要大量“原文-译文”对的数据,例如加拿大议会的英法双语记录、联合国文件等。

- 统计模型:

- 翻译模型:计算源语言句子中某个词串翻译成目标语言某个词串的概率,计算“我喜欢你”翻译成 "I love you" 的概率。

- 语言模型:计算目标语言句子本身是否通顺、自然的概率。"I love you" 比 "I you love" 的概率高得多。

- 工作流程:

寻找一个目标语言句子,使其在“翻译模型”和“语言模型”上的联合概率最大化 - 优点:

- 不需要人工编写规则,从数据中自动学习。

- 灵活性高,能处理一些未见过的句子。

- 缺点:

- 对数据量要求极高:需要海量高质量的平行语料。

- 质量瓶颈:翻译结果有时会不通顺,或者出现“词对词”的生硬翻译(英文的 "I" 对应法语的 "je" 或 "j'",但SMT难以根据上下文选择)。

- 模型复杂:需要多个模型(翻译模型、语言模型、词对齐模型等)协同工作,系统复杂。

第三阶段:神经机器翻译

这是当前最先进、最主流的AI翻译技术,自2025年左右兴起至今。

- 核心思想:使用一个巨大的、端到端的深度神经网络模型,直接学习从源语言句子到目标语言句子的映射,它将整个翻译过程视为一个单一的、连续的“学习任务”。

- 实现手段:

- 核心模型:循环神经网络 及其变体(如 LSTM, GRU),以及目前最先进的 Transformer 架构。

- 端到端:模型直接输入源语言句子,输出目标语言句子,中间不再有复杂的分步处理。

- 注意力机制:这是NMT突破性进展的关键,它允许模型在生成目标语言的每一个词时,都能“回头看”源语言句子,并聚焦于最相关的部分,这解决了长句翻译中信息遗忘的问题,极大地提升了翻译质量。

- 词向量:将单词或词语映射到一个高维、稠密的向量空间,在这个空间里,语义相近的词在向量空间中的距离也相近,这使得模型能更好地理解词语的深层含义和上下文关系。

神经机器翻译 的核心实现流程

以目前最先进的 Transformer 模型 为例,其实现流程如下:

步骤1:数据预处理

- 语料收集:收集大规模、高质量的双语平行语料。

- 文本清洗:去除无关字符、HTML标签、统一格式等。

- 分词:将句子切分成更小的单元(子词、词元)。"unbelievable" 可能被切分为 "un", "##believ", "##able",这有助于处理新词和形态丰富的语言。

- 数值化:将每个子词映射到一个唯一的整数ID。

步骤2:模型训练

这是最核心的环节,目标是训练好一个翻译模型。

-

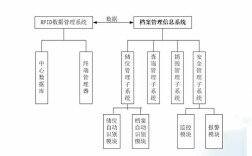

模型架构:采用 Encoder-Decoder(编码器-解码器) 结构。

- 编码器:负责读取并理解整个源语言句子,将其转换成一个包含丰富语义信息的向量表示(称为“上下文向量”或“隐藏状态”)。

- 解码器:负责根据编码器输出的信息,一个词一个词地生成目标语言句子。

-

关键机制:

-

自注意力机制:

(图片来源网络,侵删)

(图片来源网络,侵删)- 在编码器中:处理源语言句子时,让句子中的每个词都能与其他所有词建立联系,从而更深刻地理解每个词在特定上下文中的含义,在句子 "The animal didn't cross the street because it was too tired" 中,注意力机制能让模型理解 "it" 指的是 "animal"。

- 在解码器中:生成目标语言句子时,让模型能关注到源语言句子中已经翻译过的部分和即将要翻译的部分,确保翻译的连贯性和准确性。

-

位置编码:由于Transformer没有RNN那样的顺序处理机制,它无法感知词语在句子中的位置,需要通过位置编码将词语的位置信息注入到输入中。

-

-

训练目标:使用 教师强制 策略进行训练。

- 将源语言句子

S输入编码器。 - 将一个特殊的“起始符”

<sos>输入解码器,让其生成第一个目标词T1。 - 将

T1作为新的输入,让解码器生成第二个目标词T2。 - 以此类推,直到生成“结束符”

<eos>。 - 损失函数:使用交叉熵损失 来计算模型生成的整个序列与真实目标序列之间的差距,通过 反向传播算法 和 优化器(如Adam)不断调整模型中的数亿甚至数千亿个参数,使损失最小化。

- 将源语言句子

步骤3:推理/翻译

模型训练完成后,就可以用来翻译新句子了。

- 输入:一个待翻译的源语言句子。

- 过程:

- 编码器读取该句子,并输出其向量表示。

- 解码器以

<sos>作为初始输入。 - 解码器根据编码器的输出和已经生成的词,预测概率最高的下一个词。

- 将预测出的词作为新的输入,重复步骤3,直到生成

<eos>或达到最大长度限制。

- 解码策略:在预测下一个词时,可以选择:

- 贪心搜索:每次都选概率最高的词,速度快,但可能得到局部最优解。

- 束搜索:在每个步骤保留概率最高的N个候选,并继续扩展,在翻译质量和速度之间取得了很好的平衡,是目前最常用的策略。

步骤4:后处理

- 将生成的整数ID序列转换回子词序列。

- 进行子词合并,还原成单词。

- 进行简单的后处理,如去除多余的空格、标点符号修正等,得到最终的译文。

辅助技术与优化手段

为了让翻译效果更好,还会结合以下技术:

-

回译:

- 目的:解决低资源语言(如小语种)缺乏高质量平行语料的问题。

- 做法:

- 用已有的双语语料训练一个A→B的翻译模型。

- 将大量B语言的单语语料,用这个模型翻译回A语言,得到“伪双语语料”。

- 将“伪双语语料”与真实双语语料混合,重新训练或微调模型,效果会显著提升。

-

领域自适应:

- 目的:提升特定领域(如医疗、法律、金融)的翻译准确率。

- 做法:在通用模型的基础上,使用该领域的专业语料进行微调,让模型学习领域内的术语和表达习惯。

-

多语言模型:

- 目的:用一个模型同时支持多种语言之间的互译,甚至可以“零样本”翻译(模型在训练时没见过的语言对)。

- 做法:将多种语言的句子混合在一起训练,模型能学习到不同语言之间的共性,共享表示空间。

总结与对比

| 特性 | 基于规则的机器翻译 | 统计机器翻译 | 神经机器翻译 |

|---|---|---|---|

| 核心思想 | 人工编写语言转换规则 | 从数据中统计翻译概率 | 用神经网络学习端到端的映射 |

| 数据依赖 | 依赖词典和语法规则 | 依赖海量平行语料 | 依赖海量平行语料,数据效率更高 |

| 翻译质量 | 僵硬、不自然,易出错 | 较通顺,但可能生硬、不连贯 | 最自然、流畅、准确,能处理复杂语境 |

| 处理能力 | 难以处理歧义、新词、口语 | 能处理一定新词,但仍有局限 | 强大,能很好地处理歧义、长句、新词 |

| 可扩展性 | 差,每增加一种语言都需大量工作 | 一般,需要新的平行语料 | 好,可通过迁移学习、多语言模型等扩展 |

| 当前地位 | 已基本被淘汰 | 在特定领域仍有应用,但非主流 | 绝对主流,所有主流翻译服务(如Google Translate, DeepL)均基于此 |

现代AI翻译技术的实现手段,其核心就是利用以Transformer架构为代表的深度神经网络,在大规模双语数据上进行端到端的训练,并结合注意力机制来精准捕捉源语言和目标语言之间的复杂对应关系,通过回译、领域自适应等技术,不断优化其在不同场景下的表现。