NFV的性能瓶颈主要源于软件的复杂性、通用硬件的限制以及虚拟化/容器化带来的开销,高性能优化是一个多层次的、系统性的工程,贯穿从硬件到应用软件的整个栈。

下面我将从核心思想、关键技术、优化方向和未来趋势四个方面来详细阐述。

核心思想:消除瓶颈,减少开销

所有NFV高性能优化技术的核心思想可以归结为两点:

- 消除瓶颈:识别并消除数据包处理路径上的性能瓶颈,通常是CPU计算、内存拷贝或I/O等待。

- 减少开销:最大限度地减少不必要的软件开销、数据拷贝和上下文切换。

为了实现这个目标,我们需要对整个数据路径进行剖析,找到最消耗资源的环节,并针对性地进行优化。

关键技术:从底层到应用层

NFV的性能优化技术可以分为以下几个层次,越靠近硬件的优化效果通常越显著。

硬件层优化

这是最根本、效果最显著的优化方向,通过硬件卸载将CPU密集型任务交给专用硬件处理。

-

SR-IOV (Single Root I/O Virtualization):

- 原理:允许一个物理PCIe设备(如网卡)被虚拟化为多个独立的虚拟功能,每个VF都可以直接分配给一个虚拟机,并拥有独立的内存空间和中断。

- 优势:VF绕过了Hypervisor的软件交换层(如Linux Bridge, OVS),实现了VM到物理网卡的直通,这极大地减少了数据包在用户空间和内核空间之间的拷贝以及上下文切换,性能接近物理机。

- 适用场景:对延迟和吞吐量要求极高的VNF,如高性能vRouter、vSwitch。

-

DPDK (Data Plane Development Kit):

- 原理:这是一个用户空间库,它通过轮询模式驱动 替代了传统的内核中断驱动,它提供了大页内存 来减少TLB Miss,并提供了无锁队列 等数据结构来避免锁竞争。

- 优势:

- 零拷贝:数据包从网卡到应用,全程在用户空间处理,避免了内核空间的开销。

- 低延迟:轮询模式消除了中断处理的延迟。

- 高吞吐:减少了系统调用和上下文切换。

- 适用场景:几乎所有需要高性能数据包处理的VNF,是现代高性能NFV的基石。

-

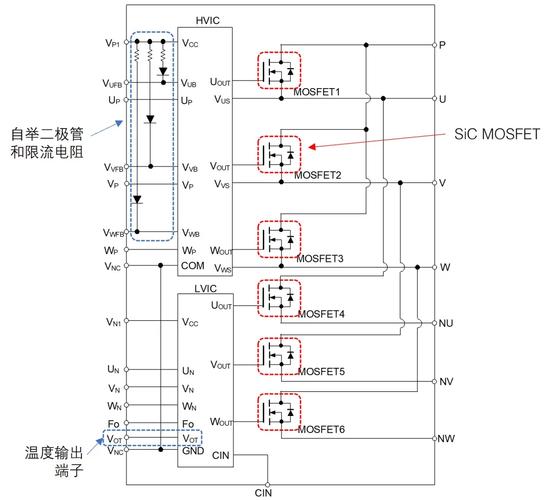

SmartNIC (智能网卡) / DPU (Data Processing Unit):

(图片来源网络,侵删)

(图片来源网络,侵删)- 原理:这是一种集成了CPU、内存和可编程网络处理单元的专用网卡,它可以在网卡内部完成复杂的网络功能卸载,如VxLAN/GRE封装/解封装、流量过滤、负载均衡等。

- 优势:

- 极致卸载:将VNF的CPU密集型任务完全从主机CPU中卸载到SmartNIC上。

- 可编程性:通过P4等语言可以灵活定义数据处理逻辑。

- 资源隔离:在SmartNIC上运行一个轻量级系统,与主机系统隔离,提升安全性和稳定性。

- 适用场景:云原生数据中心、大规模VNF部署,是实现“基础设施即服务”的关键技术。

虚拟化/容器化层优化

-

轻量级虚拟化:

- Firecracker:由AWS开源,使用轻量级的虚拟机(MicroVM),基于KVM但移除了不必要的设备模拟,启动速度快,资源开销极小,适合Serverless场景下的NFV。

- Kata Containers:结合了容器和虚拟机的优点,每个容器都在一个独立的微虚拟机中运行,提供更强的安全隔离性,同时保持了接近容器的性能。

-

容器运行时优化:

- CRI-O / containerd:作为更底层的容器运行时,它们比Docker更轻量、更专注于Kubernetes的容器生命周期管理,减少了不必要的抽象层,有助于提升性能。

数据平面与内核优化

-

内核旁路:

- 原理:完全绕过操作系统内核,让应用程序直接与硬件交互。

- 技术:除了DPDK,还有 SPDK (Storage Performance Development Kit),它用于优化存储I/O,实现了NVMe设备的用户空间访问,对需要高性能存储的VNF(如vFirewall日志存储)至关重要。

-

eBPF (extended Berkeley Packet Filter):

- 原理:Linux内核内的一种强大的、安全的、可编程的字节码引擎,它允许在内核中安全地运行沙箱化的程序,而无需修改内核代码或加载内核模块。

- 优势:

- 高性能:在内核内部处理数据包,延迟极低。

- 灵活性:可以实现复杂的流量监控、负载均衡、安全策略等。

- 可观测性:是云原生网络可观测性的利器,可以跟踪系统调用和网络事件。

- 适用场景:Cilium(基于eBPF的CNI插件)、服务网格(如Istio)、高级网络和安全策略。

-

XDP (eXpress Data Path):

- 原理:是eBPF的一个应用,它在网络驱动的最早入口点(即NAPI轮询的入口)执行eBPF程序。

- 优势:这是Linux内核中处理数据包最快的路径,因为它在驱动层就完成了处理,避免了协议栈的开销,性能是DPDK的有力竞争者。

编程模型与架构优化

-

DPDK + VPP (Vector Packet Processing):

- 原理:VPP是一个基于DPDK的高性能、可扩展的交换机/路由器框架,它采用向量化数据包处理,一次处理一批数据包,而不是一个一个地处理,这极大地提高了CPU缓存的命中率。

- 优势:性能极高,架构模块化,易于扩展和调试,是许多商业NFV解决方案的核心数据平面。

-

用户态协议栈:

- 原理:将TCP/IP协议栈实现在用户空间(如MUSK-L、LWIP),由应用程序直接调用。

- 优势:避免了内核协议栈的上下文切换和内存拷贝,对于需要处理大量短连接的场景(如DNS、负载均衡)性能提升显著。

-

架构优化:

- Service Function Chaining (SFC) / Service Graph:优化VNF的部署顺序和数据流路径,将高吞吐量的VNF(如负载均衡器)放在前面,将高CPU开销的VNF(如深度包检测DPI)放在后面,并尽可能减少VNF之间的网络跳数。

- FP (Function Placement) / 拓扑感知:根据VNF的性能要求和资源消耗,智能地将VNF实例部署在最优的服务器节点上,以减少网络延迟和资源争用。

主要优化方向总结

| 优化方向 | 核心技术 | 解决的问题 | 优势 |

|---|---|---|---|

| 硬件卸载 | SR-IOV, SmartNIC/DPU | CPU密集型任务、I/O瓶颈 | 接近物理线速性能,资源隔离 |

| 内核旁路 | DPDK, SPDK, XDP | 内核中断、系统调用、内存拷贝 | 极低延迟,极高吞吐 |

| 可编程内核 | eBPF | 灵活性、可观测性、内核内策略执行 | 高性能、安全、无需修改内核 |

| 高效处理模型 | VPP (向量化处理) | CPU缓存不友好,指令流水线 | 提高CPU效率,性能卓越 |

| 轻量级虚拟化 | Firecracker, Kata Containers | 虚拟机启动慢、资源开销大 | 启动快,资源占用少,兼顾性能与安全 |

| 智能编排 | SFC优化、FP | 次优的VNF部署顺序和拓扑 | 减少网络延迟,均衡资源负载 |

未来趋势

- SmartNIC/DPU的普及:SmartNIC/DPU正从一个“锦上添花”的选项,转变为云原生数据中心的基础设施标配,它将承担越来越多的网络、存储和计算任务,重新定义数据中心架构。

- eBPF的全面统治:eBPF正在从一个网络工具演变为整个Linux系统的可观测性和安全性的“钩子”,越来越多的VNF管理和控制平面功能将通过eBPF来实现,以获得内核级的性能。

- WAN Coexistence (共存):在WAN边缘场景,需要同时处理WAN加速(如压缩、加密)和NFV功能,未来的优化技术将更注重将这些功能在SmartNIC或用户态进行融合处理,避免功能叠加带来的性能损失。

- AI/ML for Performance Tuning:利用机器学习来动态地预测流量模式、自动调整VNF参数、智能地进行资源调度和故障自愈,实现NFV性能的“自动驾驶”。

- Rust等内存安全语言的应用:为了解决C/C++在VNF开发中的内存安全问题,Rust等语言因其高性能和内存安全保证,开始在数据平面开发中获得关注,有望构建更安全、更可靠的VNF。

NFV的高性能优化是一个系统工程,没有“银弹”,它需要开发者根据具体的应用场景(如低延迟、高吞吐、高并发)和硬件条件,选择合适的技术组合。

- 对于追求极致性能的场景,DPDK/VPP + SmartNIC 是黄金组合。

- 对于追求灵活性和可观测性的场景,eBPF/XDP 是不二之选。

- 对于云原生和Serverless场景,Firecracker/Kata + 容器化 是发展方向。

随着硬件能力的不断增强和软件栈的持续演进,NFV的性能边界正在被不断拓宽,使其能够承载更加复杂和严苛的网络应用。